ปัจจุบันคงไม่มีใครไม่รู้จัก AI หรือ LLM แน่นอน เพราะไม่ว่าจะไปบรรยายที่ไหนก็จะมีคนมาพูดคุยแลกเปลี่ยนความคิดเห็นเรื่องนี้โดยตลอด ซึ่งเมื่อมีเทคโนโลยีใหม่เข้ามาก็จะมีในส่วนที่ต้องระมัดระวังมากขึ้นเช่นกัน

OWASP หรือ Open Worldwide Application Security Project ซึ่งเป็นแหล่งข้อมูลด้านความมั่นคงปลอดภัยที่น่าเชื่อถือระดับโลก จึงได้เผยแพร่รายงาน 10 ช่องโหว่หลักของระบบ Generative AI และ LLM

1. 𝗣𝗿𝗼𝗺𝗽𝘁 𝗜𝗻𝗷𝗲𝗰𝘁𝗶𝗼𝗻 การที่มีการใช้คำสั่งที่ทำให้ระบบ Generative AI ทำงานผิดปกติ ไม่ได้เป็นไปตามที่คาดหวัง.

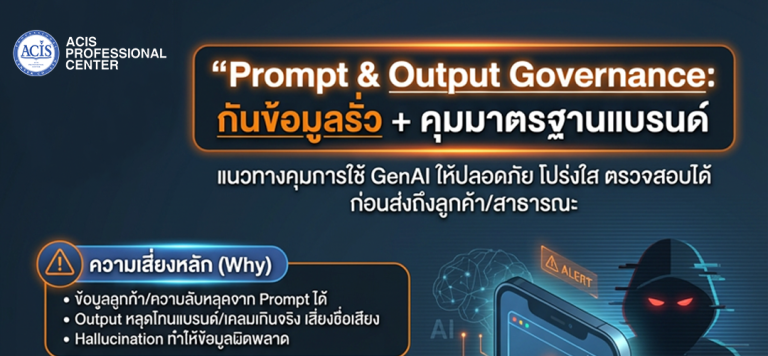

2. 𝗜𝗻𝘀𝗲𝗰𝘂𝗿𝗲 𝗼𝘂𝘁𝗽𝘂𝘁 𝗵𝗮𝗻𝗱𝗶𝗻𝗴 ประเภทช่องโหว่ที่ทำให้ผู้ไม่ประสงค์ดีสามาถเข้าถึงระบบได้.

3. 𝗧𝗿𝗮𝗶𝗻𝗶𝗻𝗴 𝗱𝗮𝘁𝗮 𝗽𝗼𝗶𝘀𝗼𝗻𝗶𝗻𝗴 ข้อมูลที่ถูกเพื่อใช้ Training ทำให้เกิดช่องโหว่เวลาถูกนำไปใช้.

4. 𝗠𝗼𝗱𝗲𝗹 𝗗𝗲𝗻𝗶𝗮𝗹 𝗼𝗳 𝗦𝗲𝗿𝘃𝗶𝗰𝗲 การใช้คำสั่งทำให้ AI ใช้ทรัพยากรมากเกินกว่าที่รับได้.

5. 𝗦𝘂𝗽𝗽𝗹𝘆 𝗰𝗵𝗮𝗶𝗻 𝘃𝘂𝗹𝗻𝗲𝗿𝗮𝗯𝗶𝗹𝗶𝘁𝘆 การโจมตีส่วนประกอบ เช่น Plugin, Outbound API โดยไม่ได้โจมตีAI โดยตรง.

6. 𝗦𝗲𝗻𝘀𝗶𝘁𝗶𝘃𝗲 𝗜𝗻𝗳𝗼𝗿𝗺𝗮𝘁𝗶𝗼𝗻 𝗗𝗶𝘀𝗰𝗹𝗼𝘀𝘂𝗿𝗲 การที่ AI ให้ข้อมูล Sensitive หรือข้อมูลในชั้นความลับสูงออกไป.

7. 𝗜𝗻𝘀𝗲𝗰𝘂𝗿𝗲 𝗣𝗹𝘂𝗴𝗶𝗻 𝗗𝗲𝘀𝗶𝗴𝗻 การที่มีการออกแบบ Plugin ที่ไม่เหมาะสมทำให้เกิดการโจมตีเข้าได้จากช่องโหว่ดังกล่าวได้.

8. 𝗘𝘅𝗰𝗲𝘀𝘀𝗶𝘃𝗲 𝗔𝗴𝗲𝗻𝗰𝘆 การที่เราตั้งค่าบางอย่างผิดพลาดทำให้ระบบทำงานผิดปกติ รวมไปถึงมีการความสอดคล้องในการทำงานร่วมกัน .

9. 𝗢𝘃𝗲𝗿𝗿𝗲𝗹𝗶𝗮𝗻𝗰𝗲 การที่ระบบไม่มีกระบวนการตรวจสอบ Output ออกจาก AI ทำให้ข้อมูลที่ได้ไม่เหมาะสมหรือไม่ถูกต้อง.

10. 𝗠𝗼𝗱𝗲𝗹 𝗧𝗵𝗲𝗳𝘁 การขโมย AI Model ซึ่งเป็นทรัพย์สินทางปัญญา และนำไปใช้ประโยชน์อย่างไม่เหมาะสม